Spis treści:

Wyszukiwarka internetowa jest jednym z najwygodniejszych źródeł informacji. Google dzięki swojej popularności zrzesza użytkowników, by poprzez odpowiednie mechanizmy wyszukiwania informacji na stronach dostarczyć konsumentowi to, czego szuka. Jednak droga do tego, by serwis pojawił się w wynikach wyszukiwania jest znacznie bardziej skomplikowana niż wpisanie hasła w wyszukiwarkę.

Jak Google przetwarza informacje ze strony?

Skomplikowany proces przetwarzania informacji jest możliwy dzięki algorytmom Google. Po wielu latach funkcjonowania na rynku wyszukiwarka udoskonaliła sposoby analizy stron internetowych. By zadowolić użytkowników odpowiednimi wynikami wyszukiwani, Google nieustannie skanuje treści pojawiające się w internecie. Wykorzystane do tego mechanizmy – czyli roboty Google – regularnie podróżują po sieci, skanują znalezione informacje i selekcjonują te, które uważają za wartościowe.

Robot Google działa w kilku krokach, aby treść dodana w serwisie pojawiła się w wynikach wyszukiwania:

- Skanowanie/Crawlowanie – roboty Googla wędrują po stronach i zapamiętują to, co znajduje się na danym serwisie.

- Indeksowanie – robot wgłębia się w treść strony,sprawdza wartość zamieszonych treści, ich aktualność oraz unikalność. Grupuje zamieszczone informacje i przypisuje je do konkretnych fraz. Dzięki temu krótkie zapytanie wpisane w wyszukiwarkę pozwala na wyświetlenie dużej ilości wyników wyszukiwania.

- Wyświetlanie wyników – umiejscowienie serwisu w wynikach wyszukiwania i wyświetlanie ich użytkownikom po wpisaniu odpowiedniej frazy.

Nie jesteśmy w stanie określić wszystkich czynników rankingowych, jakie wyszukiwarka Google bierze pod uwagę, skanując i indeksując strony. Jednak wiele wymogów dotyczących zawartości strony jest znana, dlatego serwisy mogą być odpowiednio projektowane i pojawiać się wysoko w wynikach wyszukiwania. Część czynników rankingowych dotyczy odpowiedniej optymalizacji strony internetowej, by roboty Google mogły szybko i sprawnie dotrzeć do najważniejszych elementów serwisu. Dzięki temu zwiększa się prawdopodobieństwo, że algorytmy zeskanują i zaindeksują odpowiednie źródła.

Co to jest crawl budget?

Mimo tego, że robotów Google jest wiele, to ich działanie podlega pewnym ograniczeniom. Algorytmy nie przebywają na jednej stronie przez cały czas, czekając na nowe informacje. Pojawiają się na stronie, kiedy otrzymają sygnał dotyczący aktualizacji treści w serwisie. Wtedy odwiedzają podstronę i zbierają pojawiające się na niej treści. Stąd też warto zadbać o odpowiedni crawl budget. W dużym uproszczeniu budżet indeksowania jest to ilość czasu i uwagi, jaki wyszukiwarka poświęca danej witrynie. Pojęcie określa liczbę podstron, którą algorytm może zeskanować i zaindeksować podczas jednego odwiedzenia strony. Po analizie strony Google sam dobiera odpowiednią częstotliwość crawlowania. Ze względu na różne parametry serwisów intensywność budżetu crawlowania dzieli się na kilka innych czynników.

Crawl Rate Limit

Crawl Rate Limit – czyli limit współczynnika indeksacji, który wyliczany jest na zasadzie ustawionych preferencji szybkości indeksowania strony oraz technicznych aspektów serwisu. Czynniki techniczne związane z prędkością i jakością crawlowania nazwane są crawl health. Warto więc odpowiednio wybierać serwer i hosting, tak by wydajność w tym obszarze była jak najlepsza. By współczynnik miał dobry wynik, warto zadbać o zoptymalizowanie plików na stronie. Im szybciej strona będzie reagowała na polecenia wyszukiwarki, tym większe jest prawdopodobieństwo, że będzie często odwiedzana przez roboty Google. Również odpowiednie ustawienie limitu crawlowania w Google Search Console pozwoli na zoptymalizowanie przesyłania informacji.

Crawl Demand

Crawl Demand określa częstotliwości indeksacji podstron. Im częściej użytkownicy odwiedzają serwis, tym więcej wyszukiwarka dostaje sygnałów, że pojawiają się tam treści atrakcyjne dla konsumentów. Stąd też algorytmy Google będą często odwiedzały dane źródła w internecie. Dzięki temu roboty dbają o to, by użytkownicy otrzymali aktualne informacje i chętniej wracali po więcej. Warto więc regularnie aktualizować i dodawać nowe treści na stronę tak, by Google otrzymywało sygnały o tym, że serwis dynamicznie się rozwija.

Dlaczego crawl budget jest ważny w kontekście pozycjonowania?

Dlaczego crawl budget jest ważny w kontekście pozycjonowania?

Crawl budget jest ważny dla efektywnego pozycjonowania, ponieważ im większą uwagę algorytmy będą poświęcały stronie, tym częściej aktualizacje na stronie będą wyświetlane w wynikach wyszukiwania. Gdy serwis jest często aktualizowany i tworzone są nowe podstrony, budżet indeksowania powinien być większy niż w serwisach z niewielką liczbą podstron i niezmiennymi informacjami. Ze względu na konsumentów, którzy chętnie korzystają z internetu, ważne jest, aby strona mogła dostarczyć im jak najlepsze treści. Aktualność strony wpływa na współczynnik konwersji oraz aktywne zdobywanie nowych klientów.

W przypadku gdy Google nie zaindeksuje strony, to cały wysiłek włożony w tworzenie serwisu nie zwróci się w postaci zysków. Jeśli zawartość domeny nie będzie zaindeksowana, ponieważ robot nie trafi na określone treści, to użytkownik również nie będzie w stanie skorzystać z oferowanych usług. Ze względu na to warto projektować strony internetowe z myślą o tym, by były przyjazne i dla użytkowników, i dla wyszukiwarek, ponieważ obie grupy są ze sobą ściśle związane.

Jak analizować crawl budżet – sposoby i narzędzia

Sprawdzany na bieżąco stan zeskanowania i indeksowania strony pozwala szybko znaleźć i wyeliminować problemy związane z budżetem crawlowania.

Operator

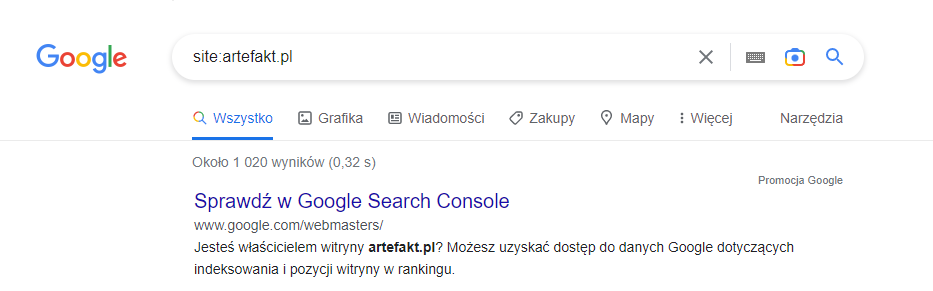

Żeby sprawdzić stan i ilość zaindeksowanych podstron w wyszukiwarce Google, wartko skorzystać z odpowiedniego operatora. W miejscu wyszukiwania zapytanie powinno zacząć się od komendy „site:”, a następnie należy wpisać adres domeny.

Przykład: site:artefakt.pl

Dzięki wpisaniu tego operatora, w liście wyników wyszukiwania znajdzie się pełna liczba zaindeksowanych podstron danego serwisu. Również po kliknięciu wyniku wyszukiwania można sprawdzić, jak Google widzi dany adres oraz czy ma jego aktualny obraz. By otrzymać aktualne informacje na temat strony, przed wykonaniem takiego wyszukiwania warto wyczyścić pamięć podręczną lub skorzystać z wyszukiwarki w wersji incognito. Pozwoli to wyeliminować wyświetlanie strony, która została zapamiętana, a nie tej wersji, która jest aktualna.

Google Search Console

Stan indeksacji i zeskanowania można łatwo sprawdzić w narzędziu Google Search Console. W zakładce „stan” wyświetlają się wszystkie aktualne informacje dotyczące serwisu okiem Google. Dzięki temu można sprawdzić, na jakim etapie dana podstrona się znajduje: czy została już zaindeksowana, czy została zeskanowana oraz czy Google widzi daną podstronę. Przy większych serwisach szczególnie trudno jest znaleźć szczegółowe informacje, dlatego warto skorzystać z opcji szybkiego wyszukiwania adresu. Wystarczy wprowadzić ścieżkę podstrony, która nas interesuje w górny panel wyszukiwania, by móc znaleźć aktualne informacje o stanie zaindeksowania oraz o tym, jak Google widzi daną podstronę. Również w tej opcji można zgłosić adres do indeksacji, tak by miał priorytetowe miejsce w kolejce. Dzięki temu na bieżąco można dbać o stan zaindeksowania podstron.

Statystyki indeksowania

Bardzo pomocna jest również sekcja statystyki indeksowania w Google Search Console, ponieważ pomaga określić obecny crawl rate strony. Dzięki temu raportowi można otrzymać informacje dotyczące:

- dziennej liczny zaindeksowanych podstron – warto monitorować ile adresów url odwiedził robot i być czujnym na ewentualne spadki, które mogą świadczyć o np. o błędach serwera;

- liczby kilobajtów pobranych przez robota – jeśli prędkość strony jest odpowiednio dobra, to roboty nie będą miały problemu z pobraniem dużej liczny danych;

- czasu spędzonego przez robota na pobieraniu danych ze strony – im mniejsza będzie wartość tego parametru, tym lepiej. Czas robota jest ograniczony, więc im szybciej sprawniej będzie mógł pobierać dane, tym większy obszar strony przeanalizuje.

Co wpływa na budżet crawlowania i jak zoptymalizować serwis pod crawl budget?

- Wydajność serwera na stronie – podczas zakładania strony internetowej, warto zastanowić się, jak wydajnego serwera będzie potrzebował nasz system. Sprawność serwera powinna być dostosowana do odpowiedniej liczby podstron, którą planujemy umieścić w strukturze serwisu, przewidywanej aktywności użytkowników strony, a także rozbudowanych i ciężkich plików, które będą pojawiać się w serwisie. W gruncie rzeczy im wydajniejszy serwer, tym lepiej, ponieważ z czasem prowadzenia strony będzie ona się rozbudowywała, więc warto zapewnić jej odpowiednie możliwości.

- Przekierowania – warto zadbać o przekierowanie adresów, które np. odpowiadają kodem 404 i nie będą zagospodarowywane w żaden inny sposób. Takie adresy niepotrzebnie widnieją w serwisie i obniżają jakość domeny. Dzięki przekierowaniu ograniczymy czas błądzenia robota po stronach serwisu, które nie są wartościowe.

- Noindex – nałożenie tagu „noindex” będzie sygnałem dla robota, że dany adres nie powinien pojawiać się w wynikach wyszukiwania – czyli nie powinien być indeksowany. Często nałożenie takiego tagu związane jest z paginacją strony czy treściami, które w serwisie się powtarzają. Jednak są sytuacje, w których nie można z nich zrezygnować, ponieważ są na przykład wynikami filtrowania lub sortowania. Dzięki nałożeniu „noindex” wyszukiwarka nie musi analizować podstron, które mogą zaszkodzić wynikom pozycjonowania i nie wnoszą nic wartościowego do struktury strony.

- Nofollow – jest to meta tag nakładany na adresy url, które niepotrzebnie będą przenosić roboty Googla na inne podstrony. Bardzo często w serwisach podlinkowane są źródła informacji, inne domeny lub media społecznościowe. Robot analizujący treść strony, natrafiając na taki adres, niepotrzebnie przeniesie się na inne serwisy i zniknie z obecnej podstrony, co skutkuje tym, że również czas crawlowania serwisu będzie znacznie krótszy i mniej efektywny.

- Kod 410 – jeśli z jakiegoś powodu właściciel serwisu chce pozbyć się określonych stron związanych z jego domeną, może skorzystać z nałożenia odpowiednich parametrów, które pozwolą stronie zwracać kod 410. Takie działanie daje znak wyszukiwarce, że powinna usunąć dany adres z wyników wyszukiwania, ponieważ już nie istnieje i serwis nie ma z nim związku. Taki kod można wykorzystać w trakcie ataku hakerskiego, by spamerskie adresy nie były wiązane dana domeną.

- Przyjazna i prosta budowa adresów URL – ten aspekt również może przyspieszyć proces crawlowania i analizowania informacji przez roboty Googla. Im jaśniejsza struktura ścieżki dostępu, tym łatwiejsza będzie ona do zrozumiana dla algorytmów, a co za tym idzie będzie uznana za wartościową.

- Linkowanie wewnętrzne – przemyślane i odpowiednio rozbudowane linkowanie wewnętrzne pomoże robotom Google trafić do odpowiednich adresów URL. Warto odpowiednio zaplanować rozmieszczenie linkowania i nie tworzyć zbyt skomplikowanych i wielopoziomowych struktur. Oczywiście wszystko trzeba dostosować do potrzeb branży i strony, jaką się prowadzi. Jednak dzięki prostej sieci połączeń między podstronami robot crawlujący, jak i użytkownik, będą łatwiej poruszali się po stronie.

Jeśli jednak nie można wpłynąć na niektóre czynniki, warto z góry określić prędkość crawlowania strony odpowiednią komendą zapisaną w pliku robots.txt. W pewnych przypadkach warto zmniejszyć prędkość skanowania adresów. Jest to dobrym rozwiązaniem w sytuacji, kiedy w trakcie intensywnego crawlowania serwer odpowiada kodem 5xx, który może być związany z jego niewydajnością. W takiej sytuacji robot Google przestaje otrzymywać informację z analizowanych stron i nie może zaindeksować prawidłowych treści. Warto więc zmniejszyć prędkość i cierpliwie poczekać na zaindeksowanie się podstron, niż za każdym razem tracić czas robota crawlującego, który nie jest w stanie pobrać żadnych informacji.

Podsumowanie

Podsumowanie

Algorytmy pracują tak, by jak najszybciej zebrać odpowiednią ilość wartościowych informacji. Jeśli techniczne aspekty strony są odpowiednio wydaje i przystosowane do skanowania przez algorytmy, to serwis powinien pojawić się szybko w wynikach wyszukiwania. Warto jednak na bieżąco analizować indeksowanie podstron, by uniknąć ewentualnych problemów. Dostosowanie crawl budgetu do możliwości serwisu zdecydowanie pomoże w osiągnięciu odpowiednich rezultatów.