Zarejestruj się do bezpłatnej platformy e-learningowej.

Zarejestruj się bezpłatnie

Sprawdź, jak Twoja strona radzi sobie w sieci!

Audytuj bezpłatnieSpis Treści

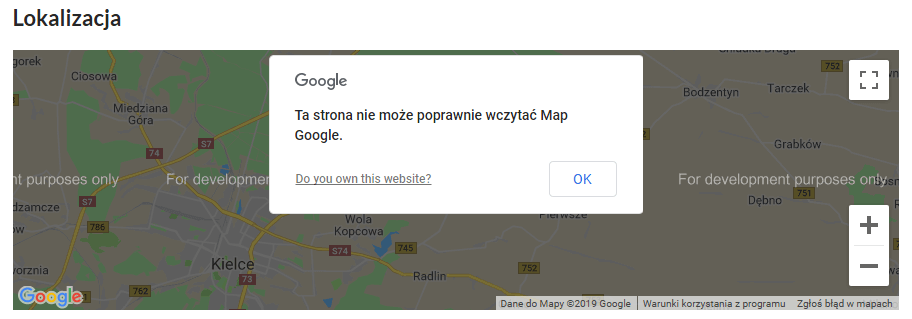

W ubiegłym roku wprowadzone zostały dodatkowe opłaty za korzystanie Google Maps osadzonych na stronach internetowych przez API. W związku z tym mapki znajdujące się w serwisach najczęściej w zakładce Kontakt przestały wyświetlać się prawidłowo, a użytkownicy widzą czarny komunikat Ta strona nie może poprawnie wczytać Map Google. Czy można naprawić mapy prezentujące lokalizację firmy i dojazd do niej? Tak, mamy na to dwa rozwiązania!

Do czerwca 2018 r. w serwisie internetowym mogliśmy zupełnie bezpłatnie zaimplementować na stronie dwa rodzaje map:

Google zdecydowało się wprowadzić opłaty za korzystanie z API, co spowodowało, że Google Maps osadzone na stronach w ten sposób przestały działać. Mapka nadal znajduje się w serwisie, ale jest wyszarzona i pojawia się komunikat informujący o jej niepoprawnym wczytaniu.

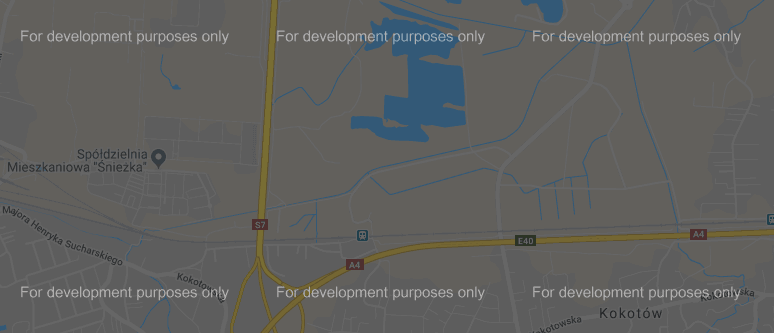

Użytkownik po pominięciu komunikatu może klikać mapę, powiększać ją i pomniejszać, zobaczyć drogę dojazdu, ale napis For development purposes only będzie przeszkadzać w dotarciu do informacji dotyczących dojazdu do firmy.

Problem związany z niedziałającymi mapkami dotyczy jedynie map osadzonych przez API, Google Maps zaimplementowane przez iFrame działają poprawnie.

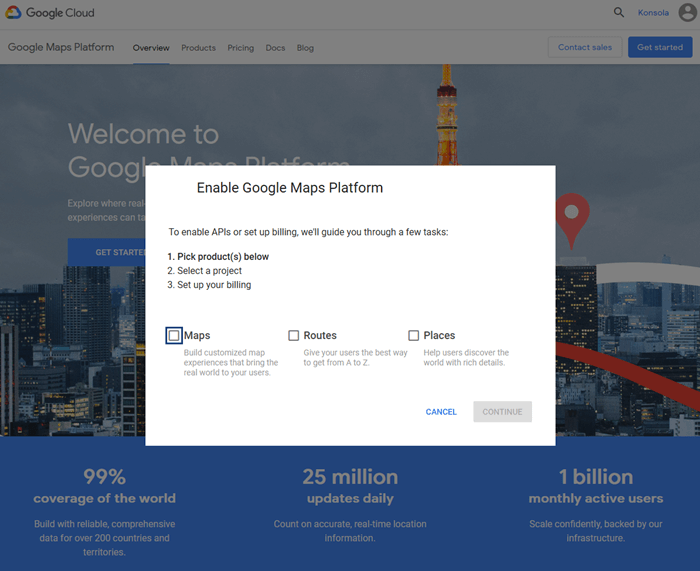

Istnieją dwa rozwiązania, aby komunikat Ta strona nie może poprawnie wczytać Map Google zniknął ze strony internetowej.

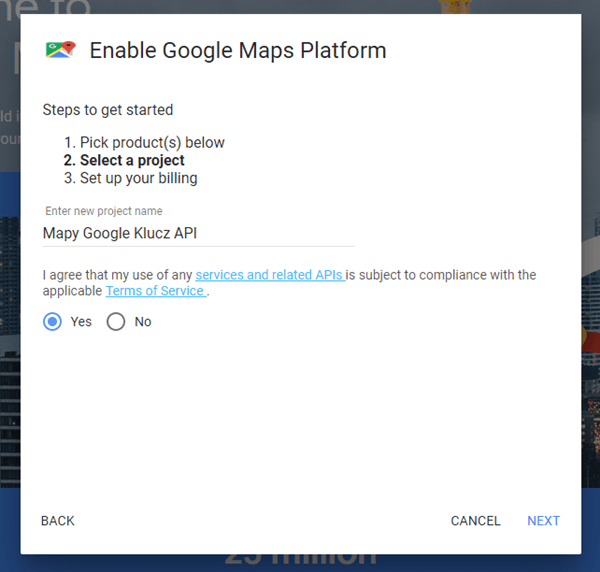

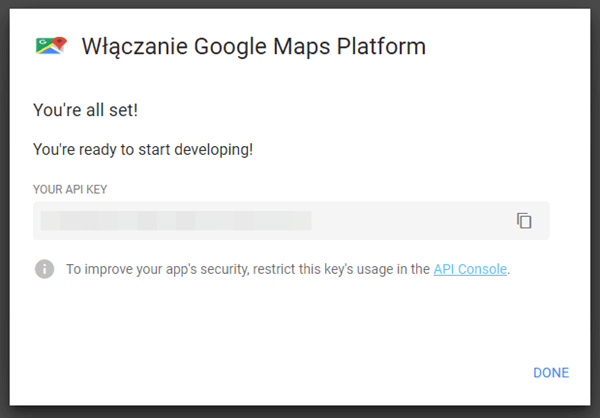

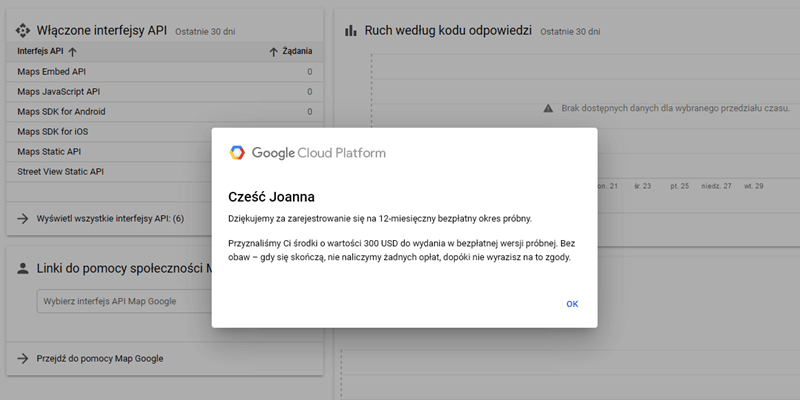

Nadal można bezpłatnie korzystać z mapek Google osadzonych przez API, jeśli skonfiguruje się konto Google Cloud Platform (https://console.cloud.google.com/projectcreate). W miesiącu każdy zalogowany użytkownik otrzymuje od Google usługi warte 200$ lub 300$, co przekłada się na np. na 25 tys. wyświetleń mapki. Po przekroczeniu darmowych limitów zostaną naliczone dodatkowe opłaty albo na naszej stronie pojawi się komunikat o niedostępności mapy (wszystko zależy od ustawień na naszym koncie Cloud Platform).

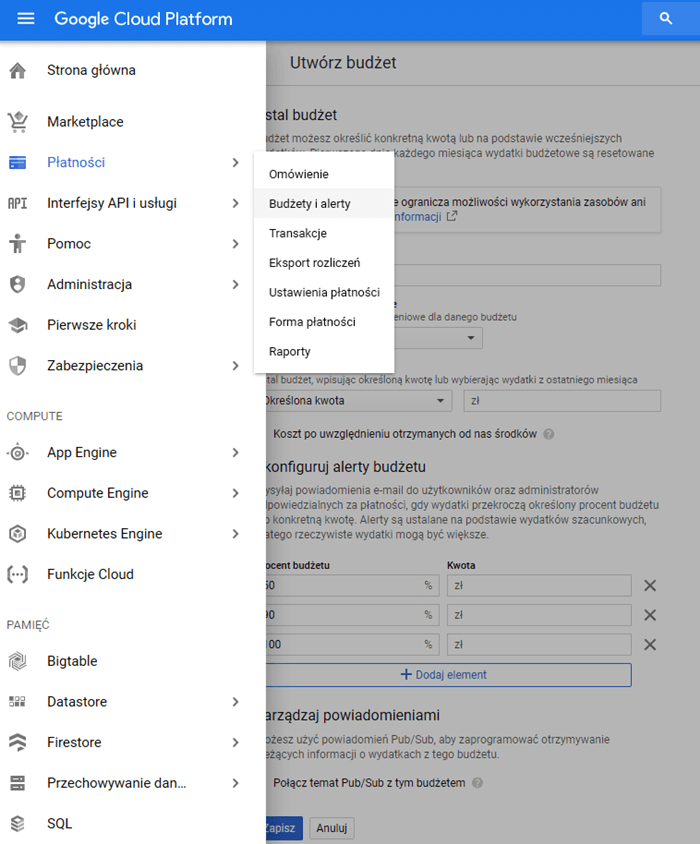

7. Gotowe! Dla pewności kartę kredytową możemy odpiąć, wchodząc do ustawień płatności w naszym koncie Google.

Dodatkowe informacje o usłudze:

https://cloud.google.com/maps-platform/user-guide/

https://cloud.google.com/maps-platform/pricing/.

Wtyczki WordPress do integracji Google Maps to niezwykle przydatne narzędzia, które pozwalają na łatwe umieszczenie mapy Google na stronie internetowej. Dzięki nim, użytkownicy mogą w prosty sposób zlokalizować interesujące ich miejsca, takie jak siedziby firm, atrakcje turystyczne czy punkty usługowe.

Wtyczki te cechują się intuicyjnym interfejsem oraz szerokim wachlarzem opcji konfiguracyjnych, co sprawia, że zarówno początkujący, jak i zaawansowani użytkownicy WordPressa mogą z łatwością dostosować mapę do swoich potrzeb. Większość wtyczek oferuje również możliwość dodawania własnych znaczników oraz personalizacji wyglądu mapy, co czyni je jeszcze bardziej atrakcyjnym rozwiązaniem dla twórców stron internetowych.

Aktualizacje i konfiguracja wtyczek w Google Maps odgrywają kluczową rolę w utrzymaniu wysokiej jakości usług oraz funkcjonalności tego popularnego narzędzia nawigacyjnego. Dzięki regularnym aktualizacjom, użytkownicy mają dostęp do najnowszych danych, takich jak zmiany w infrastrukturze drogowej czy aktualizacje miejsc.

Konfiguracja wtyczek pozwala na dostosowanie mapy do indywidualnych potrzeb, poprzez dodawanie dodatkowych warstw informacyjnych, takich jak warunki pogodowe czy informacje o ruchu drogowym. W efekcie, Google Maps staje się niezastąpionym narzędziem dla kierowców, turystów oraz przedsiębiorców, ułatwiającym codzienne życie oraz planowanie podróży.

Wtyczki do optymalizacji zużycia API w Google Maps to niezastąpione narzędzia, które pozwalają na efektywne zarządzanie usługami mapowymi. Dzięki nim, można zredukować ilość zapytań do serwerów Google, co przekłada się na niższe koszty i szybsze działanie aplikacji. Warto zatem zainwestować czas w badanie dostępnych rozwiązań, aby znaleźć najlepsze dla swoich potrzeb i cieszyć się płynnymi mapami bez obaw o przekroczenie limitów API.

Osadzanie mapek za pomocą iFrame niesie za sobą jednak jedną niedogodność – nie ma możliwości wprowadzenia spersonalizowanych ikon, informacji i znaczników, które można ustawić w mapach Google implementowanych za pomocą API.

Poprawa lokalnego SEO jest kluczowa dla rozwoju Twojej firmy w sieci. Integracja Google Maps umożliwia lepsze pozycjonowanie w wynikach wyszukiwania, co przekłada się na zwiększenie widoczności i przyciąganie nowych klientów. Dzięki tej funkcji, klienci łatwo odnajdą Twoją lokalizację, co z kolei wpłynie na wzrost popularności i zaufania do Twojej marki. Wprowadzenie Google Maps do strategii SEO jest proste i skuteczne, a korzyści płynące z tego rozwiązania są nie do przecenienia. Dochodzi również do zwiększenia użyteczności strony czy wzrostu profesjonalizmu firmy.

Śledzenie i monitorowanie komunikatów błędów Google Maps to istotny element zarządzania jakością usług mapowych. Dzięki regularnemu analizowaniu tych informacji, można szybko wykryć i naprawić ewentualne problemy, co przekłada się na lepsze doświadczenie użytkownika. Korzystając z prostych narzędzi oraz jasnych wytycznych, zarówno specjaliści, jak i zwykli użytkownicy mogą skutecznie współpracować w celu poprawy dokładności i aktualności danych mapowych.

Monitorowanie limitów zapytań oraz aktywności klucza API w Google Maps to niezwykle istotny aspekt w zarządzaniu aplikacjami wykorzystującymi mapy. Dzięki śledzeniu tych parametrów, możemy uniknąć przekroczenia dozwolonej liczby zapytań, co przekłada się na optymalizację kosztów oraz utrzymanie sprawności naszej aplikacji. Warto zatem regularnie kontrolować zużycie zasobów, korzystając z narzędzi dostarczanych przez Google. W ten sposób, będziemy mieć pewność, że nasza aplikacja działa prawidłowo, a wszelkie ograniczenia są respektowane.

Z mapek Google można korzystać nadal zupełnie bezpłatnie. Oprócz samego zamieszczenia wizytówki na stronie internetowej należy pamiętać o jej bieżącej aktualizacji i optymalizacji, aby wykorzystać potencjał Google Maps do generowania ruchu na stronie.

07.05.2025

|

czas czytania: 5:00 min

|

Inne

07.05.2025

|

czas czytania: 5:00 min

|

Inne

05.05.2025

|

czas czytania: 5:00 min

|

SEO

05.05.2025

|

czas czytania: 5:00 min

|

SEO

30.04.2025

|

czas czytania: 5:00 min

|

Inne

30.04.2025

|

czas czytania: 5:00 min

|

Inne